Giteaをサクッと動かす

自宅環境の管理にansibleを使いたくなったので、その前にgitのリポジトリを動かすことにした。

gitlabでも良いのだが、最近の動向を見ていると結構色々なものがついてきて重厚な印象があったので、今回はGiteaにした。

検証は以下のバージョンで実施した。

https://github.com/go-gitea/gitea/commit/b333e7129d26abb64cdd34e67e39cfe34fdf5bb1

動かしたか

自宅に閉じた環境なのでhttpオンリー。ホスト側の適当なポートとコンテナ内の22をつなぐとsshでも利用できると思われる。

データディレクトリをマウントしているのは、その配下に色々とデータが書かれるため。

docker run -d -v ${PWD}/data:/data/ -p 3000:3000 gitea/gitea:latest

リポジトリの見た目

気づいたこと

- 特に期待していなかったが、日本語対応がシッカリしている。

- リポジトリの機能

- オーガニゼーションが作れる

今後運用してみて知見が溜まったらまたブログにまとめる

RubyのProcess.detachを学ぶ

タイトルの通り。

マルチプロセスなEchoサーバーをRubyで書く際に、なるべくRubyの便利機能を排除して書きたかった。

Echoサーバー程度だとそもそも規模が小さいのでほぼ問題なく書けるのだが、子プロセスの扱いだけを悩んでしまった。

特に子プロセスの終了を親側で待つ必要が無いが、子プロセスの状態を回収しないとゾンビプロセスが発生してしまう。

ゾンビプロセスが湧くのはプロセスを見たときにイマイチなので回避したい。 そんなときにRubyの便利機能 Process.detach を見つけた。

どんな方法で実現されているのか?を知りたいのでコードを見ることにする。

サーッと、 Rubyの process.c というファイルを眺めていると、proc_detach が Process.detach の実装に相当していそう。

色々とコメントが付いている。

https://github.com/ruby/ruby/blob/trunk/process.c#L1132-L1175

雑に要約すると以下。

- マルチプロセスなプログラムで親プロセスが、子プロセスのステータスを回収しないと、子プロセスがゾンビになるよ

- それを防ぐために、

detachではメインのスレッドと、子プロセスを待つスレッドを分けるよ - 子プロセスを明示的に待つ必要がない時に利用してね

コメントにユースケースとかデザインとかがしっかり書き込まれているのは便利。

ESXi6.5にUSB 3.0のLAN Adaptorでnicを増やす

タイトルの通り。

ESXi6.5にUSB 3.0のLAN Adaptorでnicを増やしたかった。

手順は以下の通り。

このブログで伝えたいことは、上記の手順が、以下の商品でも問題なく動作したよ!って事。

あと、ESXiは一度Rebootしないとnicが認識されなかった。 もしかしたらネットワークのリスタートでも良いのかもしれない。

UGREEN LANアダプタ USB3.0 RJ45 ギガビットイーサネット 有線LAN 1000Mbps高速転送 Windows/Mac OS対応

- 出版社/メーカー: UGREEN GROUP LIMITED

- メディア: Personal Computers

- この商品を含むブログを見る

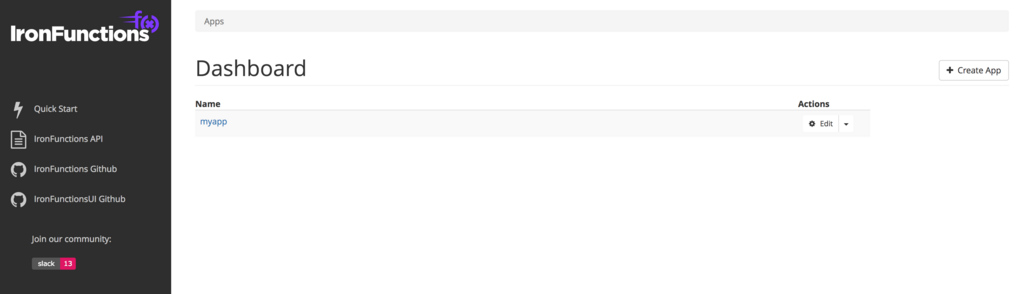

iron functions の web uiを試す

上記の続き

iron functions の web ui はきちんと開発されているよう

動かしてみる

core@coreos004 ~ $ ip a

2: ens192: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000

link/ether 00:50:56:ad:ce:53 brd ff:ff:ff:ff:ff:ff

inet 172.0.1.36/24 brd 172.0.1.255 scope global dynamic ens192

valid_lft 70170sec preferred_lft 70170sec

inet6 fe80::250:56ff:fead:ce53/64 scope link

valid_lft forever preferred_lft forever

core@coreos004 ~/iron_functions $ pwd

/home/core/iron_functions

# iron function を動かす

core@coreos004 ~/iron_functions $ docker run --rm -it --name functions -v ${PWD}/data:/app/data -v /var/run/docker.sock:/var/run/docker.sock -p 8080:8080 iron/functions

# iron function の ui を動かす

core@coreos004 ~ $ docker run --rm -it --link functions:api -p 4000:4000 -e "API_URL=http://172.0.1.36:8080" iron/functions-ui

こんな感じで docker run さえ行えば簡単に動き出す。 本当はdocker-composeなどにまとめたほうが良いのかもしれないが。

UIから出来ることは以下。

- プロジェクトを作る

- プロジェクト配下のルーティングとキックするコンテナを指定する

- 当然ルーティングの編集、削除も出来る

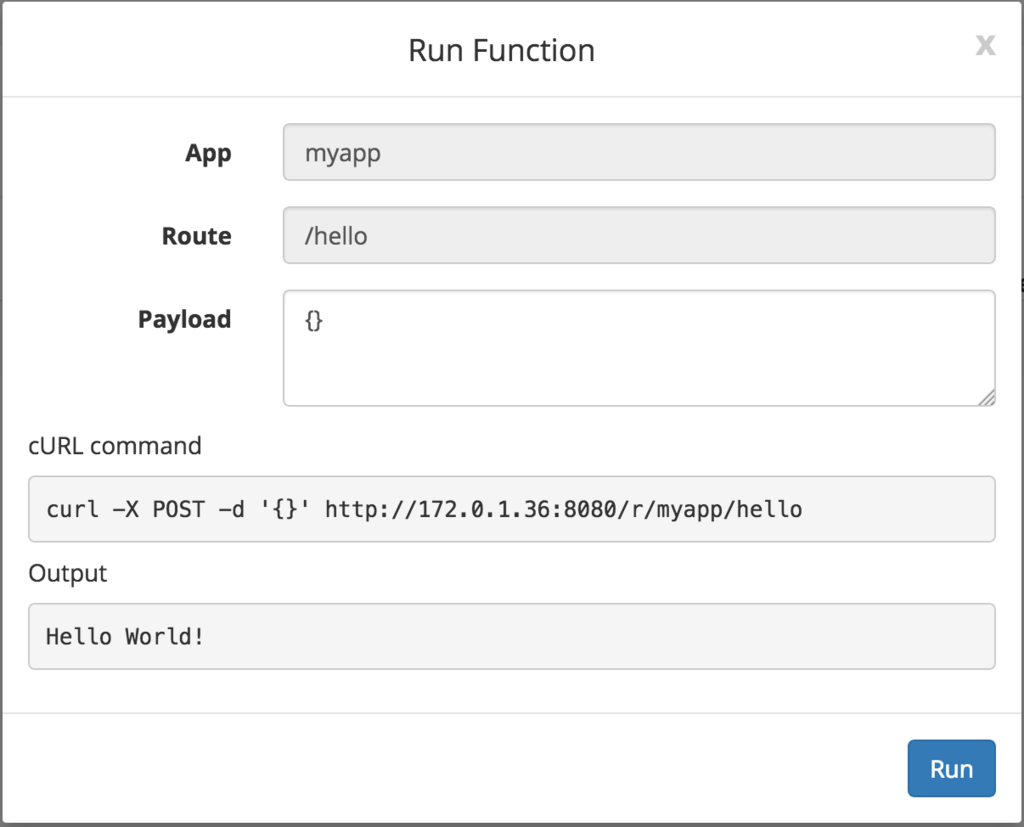

- 指定したルーティングのキックをする

- IronFunctionsのSwaggerに飛べる

UIを眺めていて、特にルーティングとキックするイメージの指定の際は、結構細かいことを指定可能な事が認識できた。 タイムアウトとか並列度とかは後日試そうと思う。

プロジェクト内のスクショ

新しいルーティングのスクショ

ルーティングを走らせるUIのスクショ

iron functions を試す

世の中がサーバーレスアーキテクチャ!と言い出して数年たった。個人的な感想としてlambdaのイベントからキックされるモデルはとても良いと思う反面、APIゲートウェイとlambdaを組み合わせるアーキテクチャは負けだなぁと感じている。

話は変わるが、エンジニアのレイヤ的にもプログラミング言語的にも多様性がある環境では、「バッチなどの処理は問題ないがAPIに仕立てるのは...」 という場面に出くわすようになる。バッチ処理をコンテナ化したらAPIサーバーに仕立ててくれるOSSが無いかなぁ?などと思って見つけたのが iron function というサーバーである。

負けだなぁと思っていたアーキテクチャも、立場と捉え方が変わると欲しかったものに変わるもんだなぁと言うことも学べた。

とりあえず今日のブログは、モチベーションが下がらないうちにチュートリアルまで。後日、CLIツールやWeb UIなども検証してブログにするつもり

Iron.io Open Source - Functions

iron functions とは?

とあるURLに対して、実行するコンテナを登録できる、AWS API Gateway と lambda を組み合わせたようなサーバー

雑に特徴を書き下すと以下のような感じ

- API

- プロジェクトの作成ができる

- プロジェクト配下のパスに、キックするDockerコンテナを登録する

http://${IP}:${PORT}/r/${PROJECT_NAME}/${REGISTER_PATH}- 登録されたパスで、Dockerコンテナをキックできる

- キックされたDockerコンテナの標準出力がAPIのレスポンスになる

- 利用可能なコンテナ

- 構築

- Docker run するだけ

- その他

- CLIがある

- Web UIがある

基本的な検証

利用環境はvSphere環境上に立てたCoreOSの上

core@coreos004 ~ $ ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens192: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000

link/ether 00:50:56:ad:ce:53 brd ff:ff:ff:ff:ff:ff

inet 172.0.1.36/24 brd 172.0.1.255 scope global dynamic ens192

valid_lft 86276sec preferred_lft 86276sec

inet6 fe80::250:56ff:fead:ce53/64 scope link

valid_lft forever preferred_lft forever

3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default

link/ether 02:42:d4:7f:04:bd brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 scope global docker0

valid_lft forever preferred_lft forever

core@coreos004 ~ $ cat /etc/os-release

NAME="Container Linux by CoreOS"

ID=coreos

VERSION=1632.3.0

VERSION_ID=1632.3.0

BUILD_ID=2018-02-14-0338

PRETTY_NAME="Container Linux by CoreOS 1632.3.0 (Ladybug)"

ANSI_COLOR="38;5;75"

HOME_URL="https://coreos.com/"

BUG_REPORT_URL="https://issues.coreos.com"

COREOS_BOARD="amd64-usr"

core@coreos004 ~ $ docker version

Client:

Version: 17.09.1-ce

API version: 1.32

Go version: go1.8.5

Git commit: 19e2cf6

Built: Thu Dec 7 22:19:00 2017

OS/Arch: linux/amd64

Server:

Version: 17.09.1-ce

API version: 1.32 (minimum version 1.12)

Go version: go1.8.5

Git commit: 19e2cf6

Built: Thu Dec 7 22:19:00 2017

OS/Arch: linux/amd64

Experimental: false

構築

適当にディレクトリをほって、docker run するだけ

core@coreos004 ~/iron_functions $ pwd

/home/core/iron_functions

core@coreos004 ~/iron_functions $ docker run --rm -it --name functions -v ${PWD}/data:/app/data -v /var/run/docker.sock:/var/run/docker.sock -p 8080:8080 iron/functions

動作チェックは手元のPCから以下のコマンド

⋊> ~ curl http://172.0.1.36:8080

{"goto":"https://github.com/iron-io/functions","hello":"world!"}

チュートリアル的な

プロジェクト作成 -> パスとコンテナの登録 -> 実行

プロジェクト名はmyapp, パスはhello, 実行するコンテナはiron/hello となっており、最終的には http://172.0.1.36:8080/r/myapp/hello でAPIが叩けるようになる

まずプロジェクトの作成を手元のPCからcurlで実行

#コマンド

curl -H "Content-Type: application/json" -X POST -d '{"app": { "name":"myapp" }}' http://172.0.1.36:8080/v1/apps

#レスポンス

{"message":"App successfully created","app":{"name":"myapp","config":null}}

パスの登録も手元のPCからcurlで実行

#コマンド

curl -H "Content-Type: application/json" -X POST -d '{

"route": {

"path":"/hello",

"image":"iron/hello"

}

}' http://172.0.1.36:8080/v1/apps/myapp/routes

# レスポンス

{"message":"Route successfully created","route":{"app_name":"myapp","path":"/hello","image":"iron/hello","memory":128,"headers":{},"type":"sync","format":"default","max_concurrency":1,"timeout":30,"idle_timeout":0,"config":{},"jwt_key":""}}

コンテナの動作チェック。ちなみに初回実行時はコンテナのpullで多少時間がかかる

curl http://172.0.1.36:8080/r/myapp/hello

出力

Hello World!

まとめ

とりあえず、コンテナを登録して実行するところまでは速攻で終わった。めちゃ簡単。

前述のとおり、明日にでもWebUIとCLIを試した記事を挙げるつもり。

VMware環境でContainerLinux (CoreOS) の基本的プロビジョニングの仕方

ものすごい今更感のあるネタだけれども、世の中に出回っている情報が???という気持ちがしたので書いておく。

ESXiにCoreOSをインストールするには?みたいなことを調べる、以下の様な情報が出て来る。

上記は2015年の記事で、おそらく現在は当時と事情が異なる。(はず。)

大前提

- OVAをデプロイしようとすると最後にカスタマイズのウィザードが出て来る

- そこでcloud-configを指定してあげたら終了

- 学習目的であればKBの通り一旦オートログインでcloud-configを作るほうが便利

- つまり動くcloud-configがあれば、auto-loginなぞ有効にしなくても良いということ。

実際に出てくるウィザード

こんなに丁寧に、cloud-configのURLは?と聞かれているので、適当なファイルサーバーを作ってそこからダウンロードするようにしたら良い。

もしくは、その2段上のInline cloud-config を使っても良いかもしれない。が、Inlineの方は、改行が微妙な事になっているので自分では検証していない。

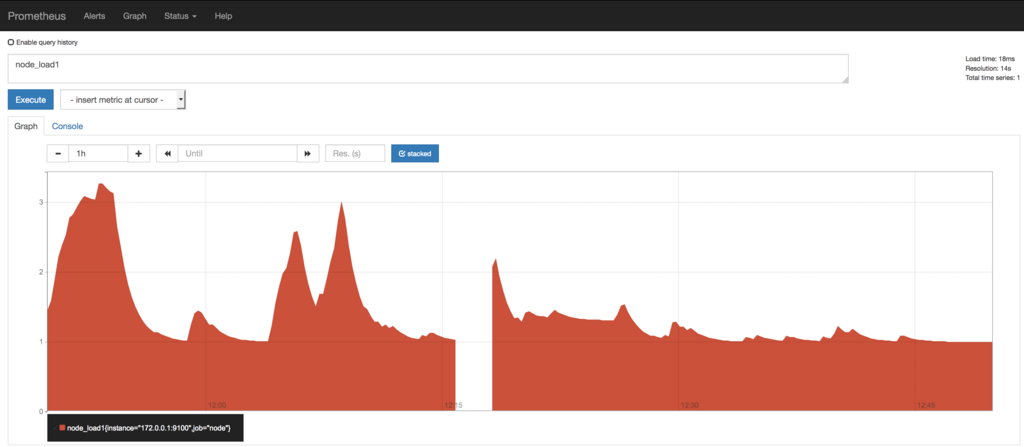

EdgeRouter X を Prometheus の node_exporter でメトリクス収集をしてみる

世の中にzabbixとMackerelは実際の知見があったけど、Prometheusを利用してEdgeRouterのメトリクス収集の知見は多く無さそうだったし、今後Prometheusを活用できないのは困るので、練習として。

ただし、EdgeRouter(≒VyOS≒Vyatta) にサービスを追加するのをきちんと取り組もうとする (=vyosのインターフェースで色々と設定できるようにしてあげる) と死ぬほど大変そうなので、一旦はnode_exporterが問題無さそうに動くまで。

自分の記事で扱う範囲は、EdgeRouterにnode_exporterを設置するところまでなので、Prometheusサーバーの構築等は他の記事を参考にしてください。

方針

- EdgeRouterをMackerelで監視する方法が世の中に知見として転がっているので、それを真似する。

- Mackerel-agent も node_exporter も golang で書かれていて、知見の転用がし易いから

- EdgeRouter上で追加のサービスをきちんと動かすための知見が少ないのでそこもお手軽にやる。

- メトリクスに関しては後日整備する

やったこと

Prometheusの入門を眺める

node_exporterをコンパイルする。

自分はmacの上でコンパイルして、EdgeRouterに持っていった。

go get github.com/prometheus/node_exporter

cd ${path}/${to}/node_exporter

env GOOS=linux env GOARCH=mipsle go build node_exporter.go

EdgeRouterのCPUは普段使うPCとアーキテクチャが違うけど、こういうときにgolangのクロスコンパイルの便利さが効いてくるなぁと思った。

EdgeRouterにコンパイル後のバイナリを置く

後述するinitスクリプトの兼ね合いで /opt/promehteus/node_exporter にした。

node_exporeter用のinit scriptを設置する

EdgeRouterはinit.d でサービスを取り扱っているので、以下のスクリプトをパクらせてもらって /etc/init.d/node_exporter とした。

Init.d script for prometheus node exporter · GitHub

自分でいじったのは、USERを prometheus から root にしたくらい。

実際の起動

sudo /etc/init.d/node_exporter start

Rebootしても大丈夫にする

EdgeRouterのOSの元になっているDebianとかでは chkconfig はなく、 update-rc.d などを使うことになっているが、 EdgeRouter内には無い雰囲気。

ので、今回はお手軽に /etc/rc.local に /etc/init.d/node_exporter start を追記しておくことにする。

確実にもっといい方法があるのだけど、EdgeRouterのお作法がよくわからなかったので一旦はこれで。

実際の雰囲気

自分のルーターは 172.0.0.1 で動いているので以下のようになった。途切れているのはrebootした所で、監視のダウンタイムは大体3分くらい。